Benchmarktests für selbstgehostete Sprachmodelle: Warum Vergleichen grüner macht

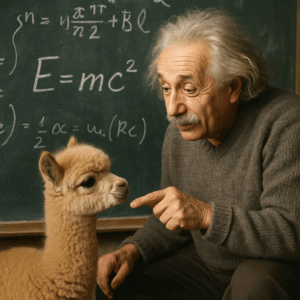

Albert Einstein wird gern zitiert mit dem Satz:

„Wenn du es einem Kind nicht erklären kannst, hast du es nicht verstanden.“

Doch was, wenn wir heute nicht einem Kind, sondern einer künstlichen Intelligenz die Relativitätstheorie erklären lassen – für ein Kind?

Willkommen in der Welt der Language Model Benchmarks – und einem Tool, das uns zeigt, wie gut (oder schlecht) eine KI wirklich antwortet: AlpacaEval.

Warum brauchen wir Benchmarktests für Sprachmodelle?

Sprachmodelle wie ChatGPT, Mistral, LLaMA & Co. sind längst in unserem Alltag angekommen:

im Kundenservice, bei der Texterstellung, im Coding – oder als Grundlage für intelligente Chatbots, die Webseitenbesucher:innen kompetent beraten.

Aber wie misst man eigentlich, ob ein Modell gut ist?

Und vor allem: Wie gut ist mein selbstgehostetes Modell im Vergleich zu kommerziellen Cloud-KIs?

Genau hier kommen Benchmark-Tools ins Spiel. Sie helfen dabei, Sprachmodelle objektiv, reproduzierbar und sinnvoll zu bewerten. Das ist wichtig, um…

- die Qualität der Antworten zu vergleichen

- Optimierungspotenzial zu erkennen

- ressourcenschonendere Modelle zu priorisieren

Was ist AlpacaEval?

AlpacaEval ist ein Open-Source-Benchmarking-Tool, das Sprachmodelle im Direktvergleich bewertet. Die Methode ist einfach, aber effektiv:

- Zwei Modelle beantworten dieselbe Frage.

- Ein drittes Modell (der sogenannte Reviewer) bewertet, welche Antwort besser ist – bezogen auf Klarheit, Relevanz, Hilfreichsein.

- Das Tool berechnet daraus eine Punktzahl für jedes Modell.

Dieser Vergleich ist praxisnäher als viele klassische Metriken wie BLEU oder perplexity. Denn er misst nicht, wie ähnlich eine Antwort dem Trainingstext ist, sondern wie hilfreich sie im echten Leben wirkt.

Was hat das mit Green IT zu tun?

Ganz einfach: Effizienz.

Nicht jedes Modell, das beeindruckende Antworten liefert, ist auch ressourcenschonend. Und Rechenpower ist teuer – für Geldbeutel und Klima.

Wer nachhaltige KI entwickeln oder nutzen möchte, muss wissen:

Welche Modelle liefern mit möglichst wenig Ressourcen möglichst gute Antworten?

Gerade bei selbstgehosteten Sprachmodellen ist dieser Punkt kritisch. Sie laufen oft auf kleinerer Infrastruktur, verbrauchen trotzdem signifikant Strom – und müssen sich daher besonders gut kalkulieren lassen.

AlpacaEval bietet genau das: einen Weg, gute Kompromisse zwischen Qualität und Rechenaufwand zu identifizieren.

Chatbots & Co.: Anwendungsmöglichkeiten für selbstgehostete Modelle

Selbstgehostete Sprachmodelle bieten nicht nur Vorteile in Sachen Datenschutz und Kontrolle – sie sind auch ideal für spezialisierte Anwendungen, bei denen man nicht auf große Cloudlösungen angewiesen sein will. Zum Beispiel:

- Chatbots auf der eigenen Website, die datenschutzkonform und effizient Auskunft geben

- Automatisierte Kundenkommunikation im Support

- Texterstellung oder -prüfung im internen Redaktionssystem

- Programmierhilfe in Entwickler:innen-Tools

- Lokale Wissensdatenbanken oder Dokumentenanalyse

Für all diese Einsatzzwecke gilt: Je besser die Antwortqualität bei geringerem Ressourcenverbrauch, desto sinnvoller der Einsatz – technisch und ökologisch.

Selbstgehostete Modelle vs. Cloud-KI: David gegen Goliath?

Es ist kein Geheimnis: Sprachmodelle aus der Cloud – wie GPT-4 – sind oft mächtiger, weil sie auf gigantischen Serverfarmen laufen. Aber sie sind auch intransparent, energieintensiv und selten DSGVO-konform.

Selbstgehostete Modelle bieten dafür:

✅ mehr Kontrolle

✅ bessere Datenschutz-Optionen

✅ Hosting mit Ökostrom (z. B. wie bei uns auf Island)

✅ kürzere Wege – lokal statt hyperscale

Aber sie bringen auch Herausforderungen mit: kleinere Modelle, begrenzter RAM, weniger Parallelisierung. Hier hilft AlpacaEval, den Sweet Spot zu finden: Welches Modell liefert auf meiner Hardware die beste Leistung bei vertretbarem Ressourcenverbrauch?

Die Schattenseite von Benchmarks: Ranking statt Verantwortung?

So hilfreich Rankings und Scores sind – sie haben auch eine dunkle Seite. Denn wenn Entwickler:innen und KI-Firmen nur noch für den „Highscore“ bei bestimmten Benchmarks optimieren, leidet oft die echte Qualität.

Die Macher:innen von AlpacaEval wissen das. Sie betonen die Bedeutung von:

- Transparenz bei Trainingsdaten und Bewertungsfragen

- Offenlegung der Benchmarkprozesse

- unabhängigen Audits

Das Ziel: Vergleiche ermöglichen – ohne Manipulation zu fördern.

Fazit: Vergleichen, um besser zu werden

Wer mit KI arbeitet – ob im Support, mit Chatbots oder zur Texterstellung – sollte wissen, was die eigene Lösung wirklich kann. Und wer KI nachhaltiger machen möchte, kommt an der Frage der Effizienz nicht vorbei.

Tools wie AlpacaEval helfen dabei, diese Fragen zu beantworten – objektiv, offen und community-getrieben.

Wir bei Green Wide Web setzen uns genau dafür ein:

🌱 Eine KI, die nicht nur klug antwortet – sondern das auch mit Rücksicht auf Energie, Umwelt und Gesellschaft.

Häufige Fragen rund um KI-Benchmarking

Wie misst man die Qualität eines KI-Sprachmodells?

Die Qualität eines KI-Sprachmodells wird in der Praxis meist durch sogenannte Benchmarks gemessen. Dabei beantworten mehrere Modelle dieselbe Frage – und ein unabhängiges Bewertungssystem (oft ein weiteres Modell) entscheidet, welche Antwort hilfreicher oder verständlicher ist. Tools wie AlpacaEval nutzen genau diesen Ansatz, um realitätsnahe Vergleiche zu ermöglichen.

Warum ist ein KI-Benchmark wichtig für die Umwelt?

Benchmarks helfen, effizientere KI-Modelle zu identifizieren, die mit weniger Rechenleistung gute Ergebnisse liefern. Das spart Energie – besonders wichtig bei großen Modellen, die viel Strom verbrauchen. Wer auf ressourcenschonende KI setzt, leistet damit auch einen aktiven Beitrag zum Klimaschutz.

Kann ich mit einem Benchmark-Tool wie AlpacaEval auch die Qualität kleiner KI-Sprachmodelle testen?

Ja! Gerade für selbstgehostete, kleinere Modelle ist AlpacaEval ideal. Es zeigt, ob ein leichtgewichtiges Modell trotz begrenzter Rechenleistung gute Antworten liefert – und hilft so dabei, den besten Kompromiss zwischen Qualität und Nachhaltigkeit zu finden.

Was ist der Unterschied zwischen klassischen Metriken und Modellvergleichstools wie AlpacaEval?

Klassische Metriken wie BLEU oder ROUGE messen, wie ähnlich eine KI-Antwort dem Trainingsdatensatz ist. Tools wie AlpacaEval hingegen vergleichen zwei echte Antworten auf ihre Verständlichkeit und Nützlichkeit – also näher dran an der realen Nutzung und deutlich praxisrelevanter.

Ist Benchmarking auch für Datenschutz und DSGVO relevant?

Ja – besonders bei selbstgehosteten Modellen. Wer KI lokal und DSGVO-konform einsetzen möchte (z. B. für Chatbots oder interne Tools), sollte wissen, wie gut die eigenen Modelle wirklich performen. Benchmarks helfen dabei, Transparenz zu schaffen und fundierte Entscheidungen für den sicheren Einsatz zu treffen.